Das Einrichten einer leistungsfähigen AI-Entwicklungsumgebung im Windows Subsystem für Linux (WSL) war noch nie so einfach. Diese umfassende Anleitung zeigt Schritt für Schritt, wie Sie eine komplette AI-Entwicklungsumgebung einrichten können, die unter anderem NVIDIA CUDA für GPU-Beschleunigung, Ollama für das Hosting von lokalen LLMs, Docker für die Containerisierung und Stable Diffusion für die Generierung von KI-Bildern enthält. Diese Anleitung ist ideal für Entwickler, Datenwissenschaftler und KI-Enthusiasten und hilft dabei, eine produktionsreife Umgebung für AI-Projekte in den Bereichen LLM und Bildgenerierung zu erstellen.

Ob Sie nun neu in WSL sind oder Ihre bestehende Umgebung verbessern möchten – dieser Leitfaden behandelt alles von der grundlegenden WSL-Installation bis zu fortgeschrittenen Konfigurationen, einschließlich:

- Optimierung der WSL- und Ubuntu-Einrichtung

- Installation des NVIDIA CUDA Toolkits für GPU-Beschleunigung

- Ollama-Deployment zum Ausführen von lokalen LLMs

- Docker-Konfiguration für containerisierte Anwendungen

- Setup der Stable Diffusion WebUI für die KI-Bilderzeugung

- GPU-Überwachung und Leistungsoptimierung

1. Systeminformationen

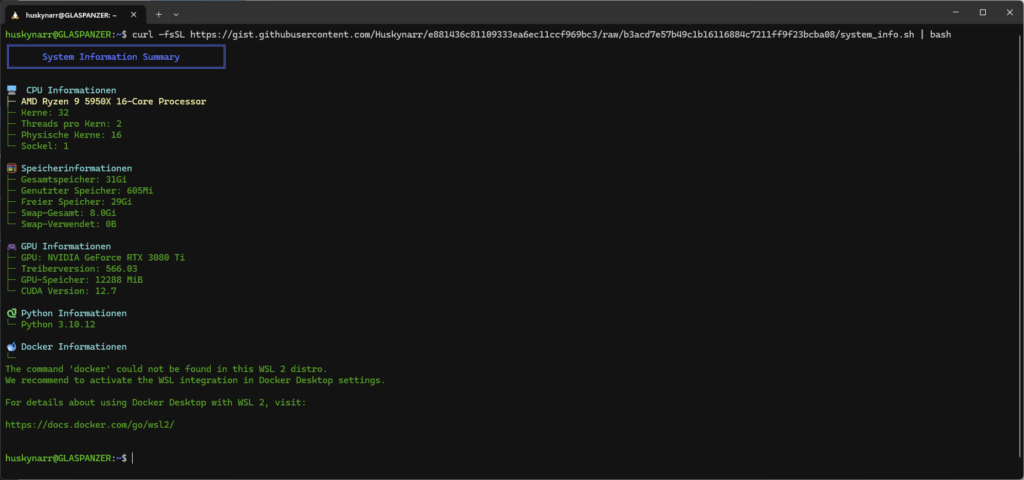

Mit folgendem Script kann man die Systemvorraussetzung prüfen:

curl -fsSL https://gist.githubusercontent.com/Huskynarr/e881436c81109333ea6ec11ccf969bc3/raw/b3acd7e57b49c1b16116884c7211ff9f23bcba08/system_info.sh | bashDieses Skript bietet eine umfassende Übersicht über die Hardware- und Software-Spezifikationen des Systems und kann einfach angepasst und ausgeführt werden, um die relevanten Informationen schnell zu erfassen.

Sofern Docker, wie im Bild noch nicht vollständig nutzbar ist, muss man die WSL Unterstützung aktivieren.

2. WSL und Ubuntu 22.04 installieren

# WSL mit Ubuntu 22.04 installieren

wsl --install -d Ubuntu-22.04

# Verbindung mit Ubuntu in einem neuen Fenster

wsl -d Ubuntu-22.04

# Neuen Benutzer erstellen (falls Sie in der Root-Shell sind)

sudo useradd -m -s /bin/bash username # 'username' ersetzen

sudo passwd username # Passwort für neuen Benutzer setzen

sudo usermod -aG sudo username # Benutzer zur Sudo-Gruppe hinzufügen

su username # Wechseln zum neuen Benutzer

# Benutzer als Standard setzen (in PowerShell ausführen)

ubuntu2204.exe config --default-user username # 'username' ersetzenSollte systemd noch nicht funktionsfähig sein, muss es entsprechend noch aktiviert werden.

3. CUDA Toolkit installieren

Es gibt zwei Optionen: manuelle Installation oder über die Kommandozeile.

Option 1: Manuelle Installation

Laden Sie CUDA von der offiziellen NVIDIA-Seite herunter und folgen Sie den Installationsanweisungen.

Option 2: Installation über die Kommandozeile

# CUDA-Repository einrichten

wget https://developer.download.nvidia.com/compute/cuda/repos/wsl-ubuntu/x86_64/cuda-wsl-ubuntu.pin

sudo mv cuda-wsl-ubuntu.pin /etc/apt/preferences.d/cuda-repository-pin-600

# CUDA herunterladen und installieren

wget https://developer.download.nvidia.com/compute/cuda/12.6.2/local_installers/cuda-repo-wsl-ubuntu-12-6-local_12.6.2-1_amd64.deb

sudo dpkg -i cuda-repo-wsl-ubuntu-12-6-local_12.6.2-1_amd64.deb

sudo cp /var/cuda-repo-wsl-ubuntu-12-6-local/cuda-*-keyring.gpg /usr/share/keyrings/

# CUDA-Toolkit aktualisieren und installieren

sudo apt-get update

sudo apt-get -y install cuda-toolkit-12-64. Ollama installieren

# Ollama installieren

curl -fsSL https://ollama.com/install.sh | sh

# Richtige Berechtigungen setzen

sudo chmod 644 /etc/systemd/system/ollama.service

# Systemd-Daemon neu laden

sudo systemctl daemon-reload

# Ollama-Dienst aktivieren und starten

sudo systemctl enable ollama

sudo systemctl start ollamaDanach muss das llama Model gedownloadet werden.

# Download von llama2

ollama pull llama2

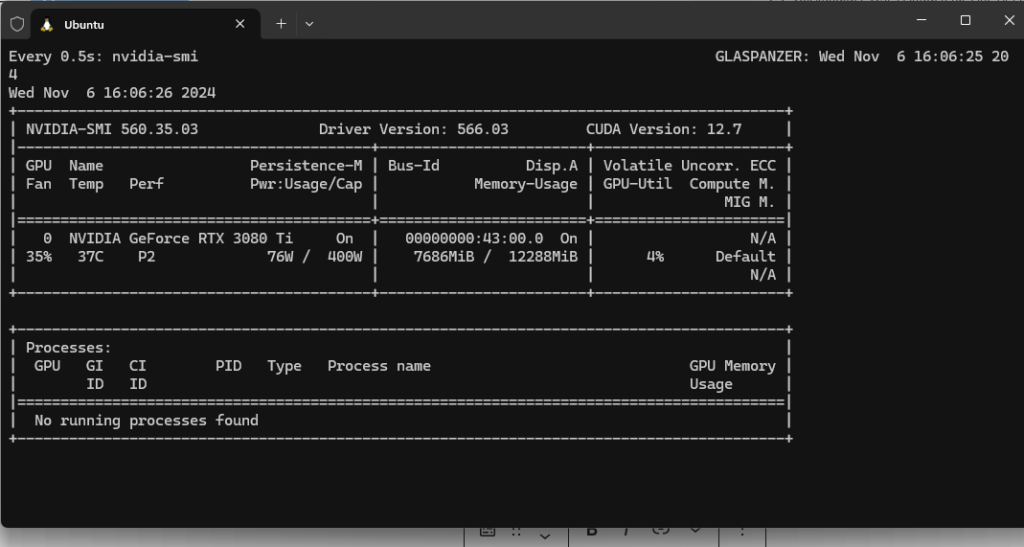

Nach der Installation muss noch überprüft werden ob die Grafikkarte aktiviert und genutzt wird:

watch -n 0.5 nvidia-smi

5. Docker installieren

# Docker-Repository hinzufügen und Docker installieren

sudo apt-get update

sudo apt-get install -y ca-certificates curl

sudo install -m 0755 -d /etc/apt/keyrings

sudo curl -fsSL https://download.docker.com/linux/ubuntu/gpg -o /etc/apt/keyrings/docker.asc

sudo chmod a+r /etc/apt/keyrings/docker.asc6. Open WebUI einrichten

Um die Open WebUI für die Generierung von KI-Bildern einzurichten, führen Sie den folgenden Befehl aus, um den Docker-Container zu starten:

docker run -d --network=host \

-v open-webui:/app/backend/data \

-e OLLAMA_BASE_URL=http://127.0.0.1:11434 \

--name open-webui \

--restart always \

ghcr.io/open-webui/open-webui:mainDie WebUI für Open WebUI wird unter http://localhost:8080 verfügbar sein.

7. Stable Diffusion installieren

Voraussetzungen: Installation von Pyenv

# Arbeitsverzeichnis einrichten

cd

mkdir stablediff

cd stablediff

# Pyenv-Abhängigkeiten installieren

sudo apt install -y make build-essential libssl-dev zlib1g-dev \

libbz2-dev libreadline-dev libsqlite3-dev wget curl llvm libncurses5-dev \

libncursesw5-dev xz-utils tk-dev libffi-dev liblzma-dev git

# Pyenv installieren

curl https://pyenv.run | bash

# Pyenv-Umgebung einrichten

echo 'export PYENV_ROOT="$HOME/.pyenv"' >> ~/.bashrc

echo '[[ -d $PYENV_ROOT/bin ]] && export PATH="$PYENV_ROOT/bin:$PATH"' >> ~/.bashrc

echo 'eval "$(pyenv init -)"' >> ~/.bashrc

source ~/.bashrc

# Aktuellen LS Hotfix anwenden (https://github.com/pyenv/pyenv/issues/1725)

cd ~/.pyenv && find . -type f | xargs sed -i $'s/\r$//' && cd -

# Python 3.10 installieren und global setzen

pyenv install 3.10

pyenv global 3.10Stable Diffusion WebUI installieren

# Installationsskript herunterladen

wget -q https://raw.githubusercontent.com/AUTOMATIC1111/stable-diffusion-webui/master/webui.sh

# Skript ausführbar machen

chmod +x webui.sh

# Systemd-Dienstdatei erstellen

sudo vi /etc/systemd/system/stable-diffusion.serviceFügen Sie diesen Inhalt in die Dienstdatei ein:

[Unit]

Description=Stable Diffusion WebUI

After=network.target

StartLimitIntervalSec=0

[Service]

Type=simple

User=username

WorkingDirectory=/home/username/stablediff/stable-diffusion-webui

ExecStart=/home/username/stablediff/webui.sh --listen --api

Restart=always

RestartSec=1

[Install]

WantedBy=multi-user.targetDienst einrichten

# Richtige Berechtigungen setzen

sudo chmod 644 /etc/systemd/system/stable-diffusion.service

# Systemd-Daemon neu laden

sudo systemctl daemon-reload

# Dienst aktivieren und starten

sudo systemctl enable stable-diffusion

sudo systemctl start stable-diffusion

# Status überprüfen

systemctl status stable-diffusion

# Logs bei Bedarf anzeigen

journalctl -u stable-diffusion -fDie WebUI für Stable Diffusion wird unter http://localhost:7860 verfügbar sein.

Zusätzliche Hinweise

- Stellen Sie sicher, dass WSL 2 ordnungsgemäß installiert und konfiguriert ist

- Vergewissern Sie sich, dass Ihr System die Mindestanforderungen für die Ausführung von CUDA und GPU-beschleunigten Anwendungen erfüllt

- Die Stable Diffusion WebUI wird nach der Installation über Ihren Webbrowser zugänglich sein

- Überwachen Sie die GPU-Auslastung mit

nvidia-smi, um sicherzustellen, dass alles ordnungsgemäß funktioniert